AI Edge Connectivity

digital – methodisch – schnell

Connectivity für ein leistungsfähiges AI-Ecosystem

AI-Cluster wollen mit einander sprechen. Nicht alle Aufgaben, insbesondere das Interferenzen, sind effektiv vor Ort ausführbar. Zugleich ist AI ein Multi-Cloud-Case, insbesondere aus Sicht der Datenhaltung und Datenakquise.

AI Connectivity nur vom feinsten !

AI Connectivity ist der Zugang zu Daten, Leistung und Kunden – die Ultrabreitband-Verbindung in die Welt. AI Edge Connectivity verbindet AI-Cluster zu einem dynamischen, selbststeuernden Netz. Es schafft die Basis für:

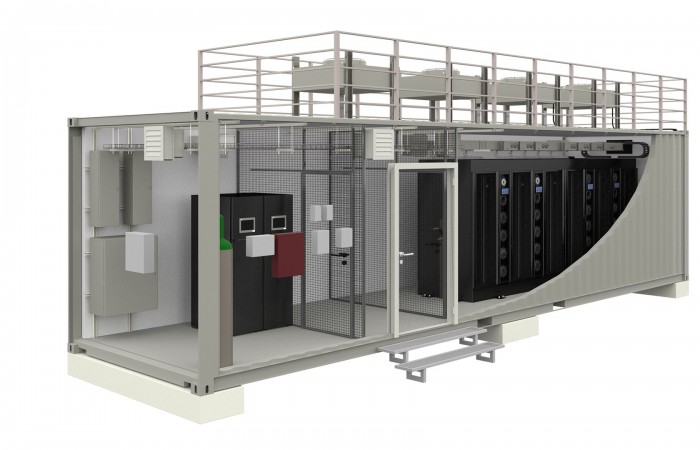

verteilte AI-Cluster, autonome Containerrechenzentren, hybride Cloud-Integrationen, und ein vollständig API-gesteuertes, souveränes AI-Ökosystem.

Edge – Core – Cloud

AIINFRAX denkt Connectivity und Intelligenz als ein mehrschichtiges Netzwerkdesign.Dabei ist Ultrabreitband & Glasfaser als Lebensader des AI-Ökosystems

Für KI-basierte Anwendungen mit massiven Datenströmen – von Edge-Sensorik bis GPU-Farm – sind Ultrabreitband-Netze (10–400 Gbit/s, später Terabit) unverzichtbar.

Edge-Layer:

- Zugang zu Lokalen AI-Clustern und FiberAccess.

- Vermittlung regionaler Anbieter.

- Anbahnung von Kooperationen

Das schafft Zugang zu:

- Dark Fiber & WDM-Technologien für dedizierte Low-Latency-Verbindungen zu regionalen Kunden.

- 5G / Private LTE-Integration für mobile Edge-Komponenten oder Campusnetze.

- Redundante Backbone-Strukturen mit Pfaddiversität und intelligenter Fehlerumschaltung.

So wird aus passiver Glasfaser ein aktiver AI-Faktor – Daten, Energie und Intelligenz fließen synchron.

Core-Layer: agiler Vernetzung zu überregionalen High-Density-Rechenzentren mit GPU- und Storage-Farmen.

Cloud-Layer: agiler Zugang zur internationalen MultiCloud und AI-Core-DC´.

Ziel ist eine performante, nahtlose Verbindung von Access, Edge, Core und Cloud zu einem Daten-Ecosystem, mit voller Kontrolle über Performance, Sicherheit und Datenflüsse.

AI Edge Connectivity im LAN

Innerhalb eines Standorts oder AI-Containers gewährleistet AI-LAN Connectivity:

Fabric-basierte Netzwerke (Leaf-Spine oder NVMe-oF): Für GPU-Cluster und schnelle Datenübertragung im Millisekundenbereich.

Software-defined Network Segmentation: KI-Workloads, Management- und Storage-Traffic sind logisch getrennt.

DCIM-Integration: Netzwerkstatus, Temperatur und Energieverbrauch in einer Oberfläche sichtbar.

AI Cluster Orchestration: Direkte Steuerung von Traffic zwischen Nodes durch AI-Controller oder Exo-Agenten.

Ergebnis: Ein deterministisches, fehlertolerantes LAN für High-Performance AI-Computing mit bis zu 400 Gbit/s pro Link.

Lokale Intelligenz, minimaler Latenzpfad

Vernetzte AI-Standorte – sicher, dynamisch und souverän

AIINFRAX setzt auf Partner, die führende Software-Defined WAN (SD-WAN) und Network-as-a-Service (NaaS) liefern können, um AI-Cluster, Colocations und Edge-Knoten intelligent zu verbinden:

NaaS-Integration: On-Demand-Verbindungen als UpLink zwischen Standorten – orchestriert über API und mandantenfähig.

Edge-to-Core-Automation: Dynamisches Routing abhängig von Latenz, Auslastung oder Energiebilanz.

End-to-End Encryption & Sovereignty: Daten bleiben im europäischen Rechtsraum (GAIA-X-konform).

QoS & Traffic Intelligence: Priorisierung von AI-Trainingsdaten, Inference-Streams und Steuerdaten.

So entsteht ein selbstoptimierendes AI-Netzwerk, das sich automatisch an Workload- und Energieanforderungen anpasst.

Ai – Infrastructure – Services